diff --git a/.gitignore b/.gitignore

old mode 100644

new mode 100755

index 29e3f06388..08ae7cfc9c

--- a/.gitignore

+++ b/.gitignore

@@ -1,8 +1,6 @@

-node_modules

+node_modules/

package-lock.json

package.json

yarn.lock

-compile.sh

-deploy.sh

-

-

+scripts/

+.DS_Store

\ No newline at end of file

diff --git a/docs/.DS_Store b/docs/.DS_Store

index 8693aee5f4..cfba763044 100644

Binary files a/docs/.DS_Store and b/docs/.DS_Store differ

diff --git a/docs/.obsidian/appearance.json b/docs/.obsidian/appearance.json

index 976ddd65bf..acf703af81 100644

--- a/docs/.obsidian/appearance.json

+++ b/docs/.obsidian/appearance.json

@@ -1,4 +1,5 @@

{

"theme": "obsidian",

- "cssTheme": "Obsidian Nord"

+ "cssTheme": "Obsidian Nord",

+ "accentColor": ""

}

\ No newline at end of file

diff --git a/docs/.obsidian/core-plugins-migration.json b/docs/.obsidian/core-plugins-migration.json

new file mode 100644

index 0000000000..318ec8585d

--- /dev/null

+++ b/docs/.obsidian/core-plugins-migration.json

@@ -0,0 +1,31 @@

+{

+ "file-explorer": true,

+ "global-search": true,

+ "switcher": true,

+ "graph": true,

+ "backlink": true,

+ "outgoing-link": true,

+ "tag-pane": true,

+ "page-preview": true,

+ "daily-notes": true,

+ "templates": true,

+ "note-composer": true,

+ "command-palette": true,

+ "slash-command": false,

+ "editor-status": true,

+ "starred": true,

+ "markdown-importer": false,

+ "zk-prefixer": false,

+ "random-note": false,

+ "outline": true,

+ "word-count": true,

+ "slides": false,

+ "audio-recorder": false,

+ "workspaces": false,

+ "file-recovery": true,

+ "publish": false,

+ "sync": false,

+ "canvas": true,

+ "bookmarks": true,

+ "properties": false

+}

\ No newline at end of file

diff --git a/docs/.obsidian/core-plugins.json b/docs/.obsidian/core-plugins.json

index 96869dfde4..30410c96ee 100644

--- a/docs/.obsidian/core-plugins.json

+++ b/docs/.obsidian/core-plugins.json

@@ -1,19 +1,32 @@

-[

- "file-explorer",

- "global-search",

- "switcher",

- "graph",

- "backlink",

- "outgoing-link",

- "tag-pane",

- "page-preview",

- "daily-notes",

- "templates",

- "note-composer",

- "command-palette",

- "editor-status",

- "starred",

- "outline",

- "word-count",

- "file-recovery"

-]

\ No newline at end of file

+{

+ "file-explorer": true,

+ "global-search": true,

+ "switcher": true,

+ "graph": true,

+ "backlink": true,

+ "outgoing-link": true,

+ "tag-pane": true,

+ "page-preview": true,

+ "daily-notes": true,

+ "templates": true,

+ "note-composer": true,

+ "command-palette": true,

+ "slash-command": false,

+ "editor-status": true,

+ "starred": true,

+ "markdown-importer": false,

+ "zk-prefixer": false,

+ "random-note": false,

+ "outline": true,

+ "word-count": true,

+ "slides": false,

+ "audio-recorder": false,

+ "workspaces": false,

+ "file-recovery": true,

+ "publish": false,

+ "sync": false,

+ "canvas": true,

+ "bookmarks": true,

+ "properties": false,

+ "webviewer": false

+}

\ No newline at end of file

diff --git a/docs/.obsidian/graph.json b/docs/.obsidian/graph.json

new file mode 100644

index 0000000000..f1c3cdafa8

--- /dev/null

+++ b/docs/.obsidian/graph.json

@@ -0,0 +1,22 @@

+{

+ "collapse-filter": true,

+ "search": "",

+ "showTags": false,

+ "showAttachments": false,

+ "hideUnresolved": false,

+ "showOrphans": true,

+ "collapse-color-groups": true,

+ "colorGroups": [],

+ "collapse-display": false,

+ "showArrow": false,

+ "textFadeMultiplier": 0,

+ "nodeSizeMultiplier": 1,

+ "lineSizeMultiplier": 1,

+ "collapse-forces": true,

+ "centerStrength": 0.518713248970312,

+ "repelStrength": 9.42057291666667,

+ "linkStrength": 0.345987955729167,

+ "linkDistance": 250,

+ "scale": 0.8171482109060346,

+ "close": true

+}

\ No newline at end of file

diff --git a/docs/.obsidian/workspace b/docs/.obsidian/workspace

index 540db7d687..2005115db2 100644

--- a/docs/.obsidian/workspace

+++ b/docs/.obsidian/workspace

@@ -4,13 +4,13 @@

"type": "split",

"children": [

{

- "id": "d328e22c3a421c71",

+ "id": "17a0267a38d6cd5c",

"type": "leaf",

"state": {

"type": "markdown",

"state": {

- "file": "data-structure-algorithms/soultion/Array-Solution.md",

- "mode": "source",

+ "file": "data-management/MySQL/MySQL-Index.md",

+ "mode": "preview",

"source": false

}

}

@@ -77,7 +77,7 @@

"state": {

"type": "backlink",

"state": {

- "file": "data-structure-algorithms/soultion/Array-Solution.md",

+ "file": "data-management/MySQL/MySQL-Index.md",

"collapseAll": false,

"extraContext": false,

"sortOrder": "alphabetical",

@@ -94,7 +94,7 @@

"state": {

"type": "outgoing-link",

"state": {

- "file": "data-structure-algorithms/soultion/Array-Solution.md",

+ "file": "data-management/MySQL/MySQL-Index.md",

"linksCollapsed": false,

"unlinkedCollapsed": true

}

@@ -117,7 +117,7 @@

"state": {

"type": "outline",

"state": {

- "file": "data-structure-algorithms/soultion/Array-Solution.md"

+ "file": "data-management/MySQL/MySQL-Index.md"

}

}

}

@@ -128,8 +128,14 @@

"direction": "horizontal",

"width": 300

},

- "active": "d328e22c3a421c71",

+ "active": "17a0267a38d6cd5c",

"lastOpenFiles": [

- "data-structure-algorithms/Array.md"

+ "interview/Kafka-FAQ.md",

+ "work/DPA.md",

+ "data-structure-algorithms/soultion/Array-Solution.md",

+ "data-structure-algorithms/Array.md",

+ "data-structure-algorithms/Recursion.md",

+ "data-management/Big-Data/Bloom-Filter.md",

+ "data-structure-algorithms/Linked-List.md"

]

}

\ No newline at end of file

diff --git a/docs/.obsidian/workspace.json b/docs/.obsidian/workspace.json

new file mode 100644

index 0000000000..d648b6a945

--- /dev/null

+++ b/docs/.obsidian/workspace.json

@@ -0,0 +1,302 @@

+{

+ "main": {

+ "id": "2c9313c97191b3d5",

+ "type": "split",

+ "children": [

+ {

+ "id": "233cec07312ea132",

+ "type": "tabs",

+ "children": [

+ {

+ "id": "17a0267a38d6cd5c",

+ "type": "leaf",

+ "state": {

+ "type": "markdown",

+ "state": {

+ "file": "data-management/MySQL/MySQL-Index.md",

+ "mode": "preview",

+ "source": false

+ },

+ "icon": "lucide-file",

+ "title": "MySQL-Index"

+ }

+ },

+ {

+ "id": "264bec0c6c3126ab",

+ "type": "leaf",

+ "state": {

+ "type": "markdown",

+ "state": {

+ "file": "data-structure-algorithms/soultion/LinkedList-Soultion.md",

+ "mode": "source",

+ "source": false

+ },

+ "icon": "lucide-file",

+ "title": "LinkedList-Soultion"

+ }

+ },

+ {

+ "id": "e24a131a4a8c13f9",

+ "type": "leaf",

+ "state": {

+ "type": "markdown",

+ "state": {

+ "file": "data-structure-algorithms/algorithm/Dynamic-Programming.md",

+ "mode": "source",

+ "source": false

+ },

+ "icon": "lucide-file",

+ "title": "Dynamic-Programming"

+ }

+ },

+ {

+ "id": "56243bd84331da43",

+ "type": "leaf",

+ "state": {

+ "type": "release-notes",

+ "state": {

+ "currentVersion": "1.8.9"

+ },

+ "icon": "lucide-book-up",

+ "title": "Release Notes 1.8.9"

+ }

+ },

+ {

+ "id": "80d5c719688f185a",

+ "type": "leaf",

+ "state": {

+ "type": "release-notes",

+ "state": {

+ "currentVersion": "1.8.10"

+ },

+ "icon": "lucide-book-up",

+ "title": "Release Notes 1.8.10"

+ }

+ },

+ {

+ "id": "c7c1397df03f59cc",

+ "type": "leaf",

+ "state": {

+ "type": "empty",

+ "state": {},

+ "icon": "lucide-file",

+ "title": "新标签页"

+ }

+ },

+ {

+ "id": "f02bfed475530fbe",

+ "type": "leaf",

+ "state": {

+ "type": "markdown",

+ "state": {

+ "file": "data-structure-algorithms/soultion/DP-Solution.md",

+ "mode": "source",

+ "source": false

+ },

+ "icon": "lucide-file",

+ "title": "DP-Solution"

+ }

+ },

+ {

+ "id": "0d9db99c2c25b1c2",

+ "type": "leaf",

+ "state": {

+ "type": "markdown",

+ "state": {

+ "file": "data-structure-algorithms/soultion/DP-Solution.md",

+ "mode": "source",

+ "source": false

+ },

+ "icon": "lucide-file",

+ "title": "DP-Solution"

+ }

+ }

+ ],

+ "currentTab": 4

+ }

+ ],

+ "direction": "vertical"

+ },

+ "left": {

+ "id": "c2ba06bd2f318734",

+ "type": "split",

+ "children": [

+ {

+ "id": "8aec8ec279c7aff1",

+ "type": "tabs",

+ "children": [

+ {

+ "id": "ae760b575766f3f0",

+ "type": "leaf",

+ "state": {

+ "type": "file-explorer",

+ "state": {

+ "sortOrder": "alphabetical",

+ "autoReveal": false

+ },

+ "icon": "lucide-folder-closed",

+ "title": "文件列表"

+ }

+ },

+ {

+ "id": "f88a42db0e3bb960",

+ "type": "leaf",

+ "state": {

+ "type": "search",

+ "state": {

+ "query": "",

+ "matchingCase": false,

+ "explainSearch": false,

+ "collapseAll": false,

+ "extraContext": false,

+ "sortOrder": "alphabetical"

+ },

+ "icon": "lucide-search",

+ "title": "搜索"

+ }

+ },

+ {

+ "id": "c7bda26138bbb70d",

+ "type": "leaf",

+ "state": {

+ "type": "starred",

+ "state": {},

+ "icon": "lucide-file",

+ "title": "插件不再活动"

+ }

+ },

+ {

+ "id": "123cfa366479ce4d",

+ "type": "leaf",

+ "state": {

+ "type": "bookmarks",

+ "state": {},

+ "icon": "lucide-bookmark",

+ "title": "书签"

+ }

+ }

+ ]

+ }

+ ],

+ "direction": "horizontal",

+ "width": 200

+ },

+ "right": {

+ "id": "4d54828aaab36d9f",

+ "type": "split",

+ "children": [

+ {

+ "id": "4acb1c44f8a68ec8",

+ "type": "tabs",

+ "children": [

+ {

+ "id": "f56e43f509009e33",

+ "type": "leaf",

+ "state": {

+ "type": "backlink",

+ "state": {

+ "file": "data-management/Redis/Redis-Datatype.md",

+ "collapseAll": true,

+ "extraContext": false,

+ "sortOrder": "alphabetical",

+ "showSearch": false,

+ "searchQuery": "",

+ "backlinkCollapsed": false,

+ "unlinkedCollapsed": true

+ },

+ "icon": "links-coming-in",

+ "title": "Redis-Datatype 的反向链接列表"

+ }

+ },

+ {

+ "id": "e22cbd6030bde448",

+ "type": "leaf",

+ "state": {

+ "type": "outgoing-link",

+ "state": {

+ "file": "data-management/Redis/Redis-Datatype.md",

+ "linksCollapsed": false,

+ "unlinkedCollapsed": true

+ },

+ "icon": "links-going-out",

+ "title": "Redis-Datatype 的出链列表"

+ }

+ },

+ {

+ "id": "37585a229386609d",

+ "type": "leaf",

+ "state": {

+ "type": "tag",

+ "state": {

+ "sortOrder": "frequency",

+ "useHierarchy": true

+ },

+ "icon": "lucide-tags",

+ "title": "标签"

+ }

+ },

+ {

+ "id": "1b738c49f6ecdf2c",

+ "type": "leaf",

+ "state": {

+ "type": "outline",

+ "state": {

+ "followCursor": false,

+ "showSearch": false,

+ "searchQuery": ""

+ },

+ "icon": "lucide-list",

+ "title": "大纲"

+ }

+ }

+ ],

+ "currentTab": 3

+ }

+ ],

+ "direction": "horizontal",

+ "width": 300

+ },

+ "left-ribbon": {

+ "hiddenItems": {

+ "switcher:打开快速切换": false,

+ "graph:查看关系图谱": false,

+ "canvas:新建白板": false,

+ "daily-notes:打开/创建今天的日记": false,

+ "templates:插入模板": false,

+ "command-palette:打开命令面板": false

+ }

+ },

+ "active": "80d5c719688f185a",

+ "lastOpenFiles": [

+ "framework/SpringWebFlux/Webflux~.md",

+ "framework/SpringWebFlux/Webflux.md",

+ "framework/SpringWebFlux/Untitled.md",

+ "framework/SpringWebFlux/响应式编程~.md",

+ "framework/SpringWebFlux/SpringWebFlux~.md",

+ "framework/SpringWebFlux/WebFlux~.md",

+ "data-management/Redis/Redis-Datatype.md",

+ "data-management/Redis/Redis-Database.md",

+ "data-management/Redis/Nosql-Overview.md",

+ "data-management/Redis/Nosql-Overview~.md",

+ "data-management/Redis/reproduce/Cache-Design.md",

+ "data-management/Redis/reproduce/Redis为什么变慢了-常见延迟问题定位与分析.md",

+ "data-management/Redis/reproduce/Key 寻址算法.md",

+ "interview/Redis-FAQ.md",

+ "data-structure-algorithms/soultion/Binary-Tree-Solution.md",

+ "未命名文件夹",

+ "java/IO~.md",

+ "java/IO.md",

+ "java/未命名.md",

+ "interview/Ability-FAQ~.md",

+ "data-structure-algorithms/algorithm/BFS.md",

+ "data-structure-algorithms/algorithm/Untitled.md",

+ "interview/Algorithm.md",

+ "interview/Alto.md",

+ "interview/Untitled.md",

+ "data-structure-algorithms/data-structure/Binary-Tree.md",

+ "data-structure-algorithms/soultion/DP-Solution.md",

+ "Untitled.canvas",

+ "data-structure-algorithms/algorithm",

+ "data-structure-algorithms/未命名文件夹"

+ ]

+}

\ No newline at end of file

diff --git a/docs/.vuepress/.DS_Store b/docs/.vuepress/.DS_Store

index 76da44d2c3..cd94417745 100644

Binary files a/docs/.vuepress/.DS_Store and b/docs/.vuepress/.DS_Store differ

diff --git a/docs/.vuepress/config.js b/docs/.vuepress/config.js

index e64f9edb72..42bf241df7 100644

--- a/docs/.vuepress/config.js

+++ b/docs/.vuepress/config.js

@@ -150,33 +150,43 @@ function genDSASidebar() {

return [

{

title: "数据结构",

- collapsable: false,

- sidebarDepth: 2, // 可选的, 默认值是 1

- children: ["Array","Linked-List","Stack","Queue","Binary-Tree","Skip-List"]

+ collapsable: true,

+ //sidebarDepth: 2, // 可选的, 默认值是 1

+ children: [

+ ['data-structure/Array','数组'],

+ ['data-structure/Linked-List','链表'],

+ ['data-structure/Stack','栈'],

+ ['data-structure/Queue','队列'],

+ ['data-structure/Binary-Tree','二叉树'],

+ ['data-structure/Skip-List','跳表']

+ ]

},

{

title: "算法",

collapsable: true,

children: [

"complexity",

- "Sort",

- ['Binary-Search', '二分查找'],

- ['Recursion', '递归'],

- ['Double-Pointer', '双指针'],

- ['Dynamic-Programming', '动态规划'],

- ['DFS', 'DFS']

+ ['algorithm/Sort', '排序'],

+ ['algorithm/Binary-Search', '二分查找'],

+ ['algorithm/Recursion', '递归'],

+ ['algorithm/Backtracking', '回溯'],

+ ['algorithm/DFS-BFS', 'DFS vs BFS'],

+ ['algorithm/Double-Pointer', '双指针'],

+ ['algorithm/Dynamic-Programming', '动态规划']

]

},

{

title: "刷题",

collapsable: true,

children: [

- ['soultion/binary-tree', '二叉树'],

+ ['soultion/Binary-Tree-Solution', '二叉树'],

['soultion/Array-Solution', '数组'],

['soultion/String-Solution', '字符串'],

['soultion/LinkedList-Soultion', '链表'],

+ ['soultion/DFS-Solution', 'DFS'],

['soultion/Math-Solution', '数学'],

- ['soultion/stock-problems', '股票问题']

+ ['soultion/stock-problems', '股票问题'],

+ ['soultion/剑指offer', '剑指offer']

]

}

];

@@ -185,19 +195,41 @@ function genDSASidebar() {

function genDesignPatternSidebar() {

return [

['Design-Pattern-Overview', '设计模式前传'],

- ['Singleton-Pattern', '单例模式'],

- ['Factory-Pattern', '工厂模式'],

- ['Prototype-Pattern', '原型模式'],

- ['Builder-Pattern', '建造者模式'],

- ['Decorator-Pattern', '装饰模式'],

- ['Proxy-Pattern', '代理模式'],

- ['Adapter-Pattern', '适配器模式'],

- ['Chain-of-Responsibility-Pattern', '责任链模式'],

- ['Observer-Pattern', '观察者模式'],

- ['Facade-Pattern', '外观模式'],

- ['Template-Pattern', '模板方法模式'],

- ['Strategy-Pattern', '策略模式'],

- ['Pipeline-Pattern', '管道模式']

+ {

+ title: "创建型模式",

+ collapsable: true,

+ sidebarDepth: 3, // 可选的, 默认值是 1

+ children: [

+ ['Singleton-Pattern', '单例模式'],

+ ['Factory-Pattern', '工厂模式'],

+ ['Prototype-Pattern', '原型模式'],

+ ['Builder-Pattern', '建造者模式']

+ ]

+ },

+ {

+ title: "结构型模式",

+ collapsable: true,

+ sidebarDepth: 3, // 可选的, 默认值是 1

+ children: [

+ ['Decorator-Pattern', '装饰模式'],

+ ['Proxy-Pattern', '代理模式'],

+ ['Adapter-Pattern', '适配器模式']

+ ]

+ },

+ {

+ title: "行为模式",

+ collapsable: true,

+ sidebarDepth: 2, // 可选的, 默认值是 1

+ children: [

+ ['Chain-of-Responsibility-Pattern', '责任链模式'],

+ ['Observer-Pattern', '观察者模式'],

+ ['Template-Pattern', '模板方法模式'],

+ ['Strategy-Pattern', '策略模式'],

+ ['Facade-Pattern', '外观模式']

+ ]

+ },

+ ['Pipeline-Pattern', '管道模式'],

+ ['Spring-Design.md', 'Spring 中的设计模式']

];

}

@@ -214,8 +246,9 @@ function genDataManagementSidebar(){

['MySQL/MySQL-Transaction', 'MySQL 事务'],

['MySQL/MySQL-Log', 'MySQL 日志'],

['MySQL/MySQL-Lock', 'MySQL 锁'],

- ['MySQL/MySQL-select', 'MySQL 查询'],

- ['MySQL/数据库三范式', '数据库三范式'],

+ ['MySQL/MySQL-Select', 'MySQL 查询'],

+ ['MySQL/MySQL-Optimization', 'MySQL 优化'],

+ ['MySQL/Three-Normal-Forms', '数据库三范式']

]

},

{

@@ -228,7 +261,7 @@ function genDataManagementSidebar(){

['Redis/Redis-Persistence', 'Redis 持久化'],

['Redis/Redis-Conf', 'Redis 配置'],

['Redis/Redis-Transaction', 'Redis 事务'],

- ['Redis/Reids-Lock', 'Redis 分布式锁'],

+ ['Redis/Redis-Lock', 'Redis 分布式锁'],

['Redis/Redis-Master-Slave', 'Redis 主从'],

['Redis/Redis-Sentinel', 'Redis 哨兵'],

['Redis/Redis-Cluster', 'Redis 集群'],

@@ -246,9 +279,7 @@ function genDataManagementSidebar(){

['Big-Data/HBase', 'HBase'],

['Big-Data/Phoenix', 'Phoneix']

]

- },

-

- 'Redis/Cache-Design'

+ }

];

}

@@ -344,7 +375,7 @@ function genNetworkSidebar(){

function genInterviewSidebar(){

return [

['Java-Basics-FAQ', 'Java基础部分'],

- ['Collections-FAQ', 'Java集合部分'],

+ ['Java-Collections-FAQ', 'Java集合部分'],

['JUC-FAQ', 'Java 多线程部分'],

['JVM-FAQ', 'JVM 部分'],

['MySQL-FAQ', 'MySQL 部分'],

@@ -355,9 +386,7 @@ function genInterviewSidebar(){

['RPC-FAQ', 'RPC 部分'],

['MyBatis-FAQ', 'MyBatis 部分'],

['Spring-FAQ', 'Spring 部分'],

- ['SpringBoot-FAQ', 'Spring Boot 部分'],

['Design-Pattern-FAQ', '设计模式部分'],

- ['Tomcat-FAQ', 'Tomcat 部分'],

['Elasticsearch-FAQ', 'Elasticsearch 部分'],

];

}

\ No newline at end of file

diff --git a/docs/.vuepress/dist b/docs/.vuepress/dist

index f970aadd9a..105cc8a4b2 160000

--- a/docs/.vuepress/dist

+++ b/docs/.vuepress/dist

@@ -1 +1 @@

-Subproject commit f970aadd9ad37262fe1b788592818ca46ea620b0

+Subproject commit 105cc8a4b28dbf98f7e847970e21da82cdaba28c

diff --git a/docs/.vuepress/public/qcode.png b/docs/.vuepress/public/qcode.png

index 22641ffb9e..0c93c28828 100644

Binary files a/docs/.vuepress/public/qcode.png and b/docs/.vuepress/public/qcode.png differ

diff --git a/docs/.vuepress/theme/.DS_Store b/docs/.vuepress/theme/.DS_Store

index 5139a2bae2..b6fd03ec58 100644

Binary files a/docs/.vuepress/theme/.DS_Store and b/docs/.vuepress/theme/.DS_Store differ

diff --git a/docs/.vuepress/theme/vuepress-theme-reco/.DS_Store b/docs/.vuepress/theme/vuepress-theme-reco/.DS_Store

index 26f6db1bae..41406f682d 100644

Binary files a/docs/.vuepress/theme/vuepress-theme-reco/.DS_Store and b/docs/.vuepress/theme/vuepress-theme-reco/.DS_Store differ

diff --git a/docs/.vuepress/theme/vuepress-theme-reco/components/.DS_Store b/docs/.vuepress/theme/vuepress-theme-reco/components/.DS_Store

index 149cc56f80..f5d0703465 100644

Binary files a/docs/.vuepress/theme/vuepress-theme-reco/components/.DS_Store and b/docs/.vuepress/theme/vuepress-theme-reco/components/.DS_Store differ

diff --git a/docs/.vuepress/theme/vuepress-theme-reco/styles/palette.styl b/docs/.vuepress/theme/vuepress-theme-reco/styles/palette.styl

index 21b758e69a..ea6620af89 100644

--- a/docs/.vuepress/theme/vuepress-theme-reco/styles/palette.styl

+++ b/docs/.vuepress/theme/vuepress-theme-reco/styles/palette.styl

@@ -20,6 +20,8 @@ $lightColor3 = rgba(255, 255, 255, .3)

$lightColor2 = rgba(255, 255, 255, .2)

$lightColor1 = rgba(255, 255, 255, .1)

+$accentColor = #2A6FDB

+

$textShadow = 0 2px 4px $darkColor1;

$borderRadius = .25rem

$lineNumbersWrapperWidth = 2.5rem

diff --git "a/docs/TODO/complexity\347\232\204\345\211\257\346\234\254.md" "b/docs/TODO/complexity\347\232\204\345\211\257\346\234\254.md"

deleted file mode 100644

index 32979ae6e1..0000000000

--- "a/docs/TODO/complexity\347\232\204\345\211\257\346\234\254.md"

+++ /dev/null

@@ -1,40 +0,0 @@

-作为一个伪高级开发,想换坑了,之前也没系统刷过算法题,今天打开LeetCode第一题,看解析突然发现大学时候学的时间复杂度、空间复杂度在我脑中只有$O(n)$、$O(0)$ 这几个符号,具体什么意思,学渣体质的我那会应该就没学会,所以,,,输入并输出一下,

-

-

-

-

-

-

-

-

-

-算法与数据结构是面试考察的重中之重,也是大家日后学习时需要着重训练的部分。简单的总结一下,大约有这些内容:

-

-

-

-## **算法 - Algorithms**

-

-1. 排序算法:快速排序、归并排序、计数排序

-2. 搜索算法:回溯、递归、剪枝技巧

-3. 图论:最短路、最小生成树、网络流建模

-4. 动态规划:背包问题、最长子序列、计数问题

-5. 基础技巧:分治、倍增、二分、贪心

-

-## **数据结构 - Data Structures**

-

-1. 数组与链表:单 / 双向链表、跳舞链

-2. 栈与队列

-3. 树与图:最近公共祖先、并查集

-4. 哈希表

-5. 堆:大 / 小根堆、可并堆

-6. 字符串:字典树、后缀树

-

-

-

-对于上面总结的这部分内容,力扣已经为大家准备好了相关专题,等待大家来练习啦。

-

-算法部分,我们开设了 [初级算法 - 帮助入门](https://leetcode-cn.com/explore/interview/card/top-interview-questions-easy/)、[中级算法 - 巩固训练](https://leetcode-cn.com/explore/interview/card/top-interview-questions-medium/)、 [高级算法 - 提升进阶](https://leetcode-cn.com/explore/interview/card/top-interview-questions-hard/) 三个不同的免费探索主题,包含:数组、字符串、搜索、排序、动态规划、数学、图论等许多内容。大家可以针对自己当前的基础与能力,选择相对应的栏目进行练习。为了能够达到较好的效果,建议小伙伴将所有题目都练习 2~3 遍,吃透每一道题目哦。

-

-数据结构部分,我们也开设了一个非常系统性的 [数据结构](https://leetcode-cn.com/explore/learn/) 板块,有练习各类数据结构的探索主题,其中包含:队列与栈、数组与字符串、链表、哈希表、二叉树等丰富的内容。每一个章节都包含文字讲解与生动的图片演示,同时配套相关题目。相信只要认真练习,一定能受益匪浅。

-

-力扣将热门面试问题里比较新的题目按照类别进行了整理,以供大家按模块练习。

diff --git a/docs/_images/.DS_Store b/docs/_images/.DS_Store

index 3e3e4c509e..90d90ebc34 100644

Binary files a/docs/_images/.DS_Store and b/docs/_images/.DS_Store differ

diff --git a/docs/_images/design-pattern/UML-type.png b/docs/_images/design-pattern/UML-type.png

deleted file mode 100644

index 35d9bd2829..0000000000

Binary files a/docs/_images/design-pattern/UML-type.png and /dev/null differ

diff --git a/docs/_images/design-pattern/abstract-factory-demo.png b/docs/_images/design-pattern/abstract-factory-demo.png

deleted file mode 100644

index 7162ebfb46..0000000000

Binary files a/docs/_images/design-pattern/abstract-factory-demo.png and /dev/null differ

diff --git a/docs/_images/design-pattern/abstract-factory-uml.png b/docs/_images/design-pattern/abstract-factory-uml.png

deleted file mode 100644

index 88ca80d309..0000000000

Binary files a/docs/_images/design-pattern/abstract-factory-uml.png and /dev/null differ

diff --git a/docs/_images/design-pattern/ali-strategy.png b/docs/_images/design-pattern/ali-strategy.png

deleted file mode 100644

index 952bd661ae..0000000000

Binary files a/docs/_images/design-pattern/ali-strategy.png and /dev/null differ

diff --git a/docs/_images/design-pattern/builder-UML.png b/docs/_images/design-pattern/builder-UML.png

deleted file mode 100644

index de7d87a074..0000000000

Binary files a/docs/_images/design-pattern/builder-UML.png and /dev/null differ

diff --git a/docs/_images/design-pattern/builder-car.png b/docs/_images/design-pattern/builder-car.png

deleted file mode 100644

index c6f41f4554..0000000000

Binary files a/docs/_images/design-pattern/builder-car.png and /dev/null differ

diff --git a/docs/_images/design-pattern/decorator-uml.png b/docs/_images/design-pattern/decorator-uml.png

deleted file mode 100644

index b534ffad1f..0000000000

Binary files a/docs/_images/design-pattern/decorator-uml.png and /dev/null differ

diff --git a/docs/_images/design-pattern/factory-method-uml.png b/docs/_images/design-pattern/factory-method-uml.png

deleted file mode 100644

index 7f6a0eb799..0000000000

Binary files a/docs/_images/design-pattern/factory-method-uml.png and /dev/null differ

diff --git a/docs/_images/design-pattern/hello-file.png b/docs/_images/design-pattern/hello-file.png

deleted file mode 100644

index 64042c701c..0000000000

Binary files a/docs/_images/design-pattern/hello-file.png and /dev/null differ

diff --git a/docs/_images/design-pattern/observer-uml.png b/docs/_images/design-pattern/observer-uml.png

deleted file mode 100644

index fa14885acb..0000000000

Binary files a/docs/_images/design-pattern/observer-uml.png and /dev/null differ

diff --git a/docs/_images/design-pattern/pipeline-pattern-csharp-uml.png b/docs/_images/design-pattern/pipeline-pattern-csharp-uml.png

deleted file mode 100644

index b465b1135f..0000000000

Binary files a/docs/_images/design-pattern/pipeline-pattern-csharp-uml.png and /dev/null differ

diff --git a/docs/_images/design-pattern/pipeline-result.png b/docs/_images/design-pattern/pipeline-result.png

deleted file mode 100644

index 1e64c5061b..0000000000

Binary files a/docs/_images/design-pattern/pipeline-result.png and /dev/null differ

diff --git a/docs/_images/design-pattern/pipeline-uml.png b/docs/_images/design-pattern/pipeline-uml.png

deleted file mode 100644

index c771d84092..0000000000

Binary files a/docs/_images/design-pattern/pipeline-uml.png and /dev/null differ

diff --git a/docs/_images/design-pattern/responsibility-pattern-uml.png b/docs/_images/design-pattern/responsibility-pattern-uml.png

deleted file mode 100644

index abc7ce238e..0000000000

Binary files a/docs/_images/design-pattern/responsibility-pattern-uml.png and /dev/null differ

diff --git a/docs/_images/design-pattern/simple-factory-uml.png b/docs/_images/design-pattern/simple-factory-uml.png

deleted file mode 100644

index f82cdab658..0000000000

Binary files a/docs/_images/design-pattern/simple-factory-uml.png and /dev/null differ

diff --git a/docs/_images/design-pattern/strategy-pattern-if-else.png b/docs/_images/design-pattern/strategy-pattern-if-else.png

deleted file mode 100644

index d67a23b714..0000000000

Binary files a/docs/_images/design-pattern/strategy-pattern-if-else.png and /dev/null differ

diff --git a/docs/_images/design-pattern/strategy-pattern-uml.png b/docs/_images/design-pattern/strategy-pattern-uml.png

deleted file mode 100644

index d36f2bc71b..0000000000

Binary files a/docs/_images/design-pattern/strategy-pattern-uml.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/DMA.png b/docs/_images/distribution/message-queue/Kafka/DMA.png

deleted file mode 100644

index a8cf48a85c..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/DMA.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/Sendfile.png b/docs/_images/distribution/message-queue/Kafka/Sendfile.png

deleted file mode 100644

index ce51efc629..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/Sendfile.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/controller-leader.png b/docs/_images/distribution/message-queue/Kafka/controller-leader.png

deleted file mode 100644

index cbab054742..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/controller-leader.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/imprint.png b/docs/_images/distribution/message-queue/Kafka/imprint.png

deleted file mode 100644

index 515369bf61..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/imprint.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/interceptor-demo.png b/docs/_images/distribution/message-queue/Kafka/interceptor-demo.png

deleted file mode 100644

index 804d1ce455..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/interceptor-demo.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-ack-slg.png b/docs/_images/distribution/message-queue/Kafka/kafka-ack-slg.png

deleted file mode 100644

index 494769ff03..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-ack-slg.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-ack=-1.png b/docs/_images/distribution/message-queue/Kafka/kafka-ack=-1.png

deleted file mode 100644

index 0647f7439d..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-ack=-1.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-ack=1.png b/docs/_images/distribution/message-queue/Kafka/kafka-ack=1.png

deleted file mode 100644

index 95be4d96a5..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-ack=1.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-apis.png b/docs/_images/distribution/message-queue/Kafka/kafka-apis.png

deleted file mode 100644

index db6053ccc2..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-apis.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-consume-group.png b/docs/_images/distribution/message-queue/Kafka/kafka-consume-group.png

deleted file mode 100644

index c3931c7a75..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-consume-group.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-leo.png b/docs/_images/distribution/message-queue/Kafka/kafka-leo.png

deleted file mode 100644

index d5f2b6e9c4..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-leo.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-partition.jpg b/docs/_images/distribution/message-queue/Kafka/kafka-partition.jpg

deleted file mode 100644

index e8cd1de32b..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-partition.jpg and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-producer-thread.png b/docs/_images/distribution/message-queue/Kafka/kafka-producer-thread.png

deleted file mode 100644

index 1ecda6e19c..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-producer-thread.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-segement.jpg b/docs/_images/distribution/message-queue/Kafka/kafka-segement.jpg

deleted file mode 100644

index 8bc98a8dd6..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-segement.jpg and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-start.png b/docs/_images/distribution/message-queue/Kafka/kafka-start.png

deleted file mode 100644

index 1080ae6a7b..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-start.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-streams-data-clean.png b/docs/_images/distribution/message-queue/Kafka/kafka-streams-data-clean.png

deleted file mode 100644

index 3c6109c9a0..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-streams-data-clean.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-structure.png b/docs/_images/distribution/message-queue/Kafka/kafka-structure.png

deleted file mode 100644

index 9778e71664..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-structure.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-tags.png b/docs/_images/distribution/message-queue/Kafka/kafka-tags.png

deleted file mode 100644

index 10dd26e699..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-tags.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-version.png b/docs/_images/distribution/message-queue/Kafka/kafka-version.png

deleted file mode 100644

index e8720f136f..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-version.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-workflow.jpg b/docs/_images/distribution/message-queue/Kafka/kafka-workflow.jpg

deleted file mode 100644

index 49ed343ac4..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-workflow.jpg and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kafka-write-flow.png b/docs/_images/distribution/message-queue/Kafka/kafka-write-flow.png

deleted file mode 100644

index 487d735acb..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kafka-write-flow.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kakfa-java-demo.png b/docs/_images/distribution/message-queue/Kafka/kakfa-java-demo.png

deleted file mode 100644

index 491cb41ad0..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kakfa-java-demo.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kakfa-principle.png b/docs/_images/distribution/message-queue/Kafka/kakfa-principle.png

deleted file mode 100644

index c1ce1730bc..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kakfa-principle.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/kakfa-streams-flow.png b/docs/_images/distribution/message-queue/Kafka/kakfa-streams-flow.png

deleted file mode 100644

index 180c313609..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/kakfa-streams-flow.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/log_anatomy.png b/docs/_images/distribution/message-queue/Kafka/log_anatomy.png

deleted file mode 100644

index a649499926..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/log_anatomy.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/log_consumer.png b/docs/_images/distribution/message-queue/Kafka/log_consumer.png

deleted file mode 100644

index fbc45f2060..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/log_consumer.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/mmap.png b/docs/_images/distribution/message-queue/Kafka/mmap.png

deleted file mode 100644

index 9b5668086f..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/mmap.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/mq.png b/docs/_images/distribution/message-queue/Kafka/mq.png

deleted file mode 100644

index 0eb2e236d7..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/mq.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/sumer-groups.png b/docs/_images/distribution/message-queue/Kafka/sumer-groups.png

deleted file mode 100644

index 16fe2936cb..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/sumer-groups.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/zero-copy.png b/docs/_images/distribution/message-queue/Kafka/zero-copy.png

deleted file mode 100644

index f9ac3ba2b3..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/zero-copy.png and /dev/null differ

diff --git a/docs/_images/distribution/message-queue/Kafka/zookeeper-store.png b/docs/_images/distribution/message-queue/Kafka/zookeeper-store.png

deleted file mode 100644

index 143f682a4a..0000000000

Binary files a/docs/_images/distribution/message-queue/Kafka/zookeeper-store.png and /dev/null differ

diff --git "a/docs/_images/distribution/message-queue/Kafka/\344\274\240\347\273\237\346\266\210\346\201\257\351\230\237\345\210\227.png" "b/docs/_images/distribution/message-queue/Kafka/\344\274\240\347\273\237\346\266\210\346\201\257\351\230\237\345\210\227.png"

deleted file mode 100644

index 8122b29cf3..0000000000

Binary files "a/docs/_images/distribution/message-queue/Kafka/\344\274\240\347\273\237\346\266\210\346\201\257\351\230\237\345\210\227.png" and /dev/null differ

diff --git a/docs/_images/interview/mysql-cache-demo.png b/docs/_images/interview/mysql-cache-demo.png

deleted file mode 100644

index ef4bfb73fe..0000000000

Binary files a/docs/_images/interview/mysql-cache-demo.png and /dev/null differ

diff --git a/docs/_images/java/.DS_Store b/docs/_images/java/.DS_Store

index 1404c41a0d..c56bcdd79b 100644

Binary files a/docs/_images/java/.DS_Store and b/docs/_images/java/.DS_Store differ

diff --git a/docs/_images/java/JVM/00831rSTly1gdeb84yh71j30yq0j6akl.jpeg b/docs/_images/java/JVM/00831rSTly1gdeb84yh71j30yq0j6akl.jpeg

deleted file mode 100644

index fbbd6934b0..0000000000

Binary files a/docs/_images/java/JVM/00831rSTly1gdeb84yh71j30yq0j6akl.jpeg and /dev/null differ

diff --git a/docs/_images/java/JVM/3j31ci0m6k5w.jpeg b/docs/_images/java/JVM/3j31ci0m6k5w.jpeg

deleted file mode 100644

index d1623c1132..0000000000

Binary files a/docs/_images/java/JVM/3j31ci0m6k5w.jpeg and /dev/null differ

diff --git a/docs/_images/java/JVM/classloader.png b/docs/_images/java/JVM/classloader.png

deleted file mode 100644

index b388d438bf..0000000000

Binary files a/docs/_images/java/JVM/classloader.png and /dev/null differ

diff --git a/docs/_images/java/JVM/error-oom.png b/docs/_images/java/JVM/error-oom.png

deleted file mode 100644

index 71476a4069..0000000000

Binary files a/docs/_images/java/JVM/error-oom.png and /dev/null differ

diff --git a/docs/_images/java/JVM/java-object.jpg b/docs/_images/java/JVM/java-object.jpg

deleted file mode 100644

index bc17bccfaf..0000000000

Binary files a/docs/_images/java/JVM/java-object.jpg and /dev/null differ

diff --git a/docs/_images/java/JVM/jvm-bytecode.png b/docs/_images/java/JVM/jvm-bytecode.png

deleted file mode 100644

index 19c7898e17..0000000000

Binary files a/docs/_images/java/JVM/jvm-bytecode.png and /dev/null differ

diff --git a/docs/_images/java/JVM/jvm-class-load.png b/docs/_images/java/JVM/jvm-class-load.png

deleted file mode 100644

index e4f7fd62b6..0000000000

Binary files a/docs/_images/java/JVM/jvm-class-load.png and /dev/null differ

diff --git a/docs/_images/java/JVM/jvm-compile.png b/docs/_images/java/JVM/jvm-compile.png

deleted file mode 100644

index 3429c6dcc9..0000000000

Binary files a/docs/_images/java/JVM/jvm-compile.png and /dev/null differ

diff --git a/docs/_images/java/JVM/jvm-dynamic-linking.png b/docs/_images/java/JVM/jvm-dynamic-linking.png

deleted file mode 100644

index d706307643..0000000000

Binary files a/docs/_images/java/JVM/jvm-dynamic-linking.png and /dev/null differ

diff --git a/docs/_images/java/JVM/jvm-framework.png b/docs/_images/java/JVM/jvm-framework.png

deleted file mode 100644

index e152cf5509..0000000000

Binary files a/docs/_images/java/JVM/jvm-framework.png and /dev/null differ

diff --git a/docs/_images/java/JVM/jvm-javap.png b/docs/_images/java/JVM/jvm-javap.png

deleted file mode 100644

index 240b310de9..0000000000

Binary files a/docs/_images/java/JVM/jvm-javap.png and /dev/null differ

diff --git a/docs/_images/java/JVM/jvm-jdk-jre.png b/docs/_images/java/JVM/jvm-jdk-jre.png

deleted file mode 100644

index a7e43e5232..0000000000

Binary files a/docs/_images/java/JVM/jvm-jdk-jre.png and /dev/null differ

diff --git a/docs/_images/java/JVM/jvm-pc-counter.png b/docs/_images/java/JVM/jvm-pc-counter.png

deleted file mode 100644

index 2a03b82c4d..0000000000

Binary files a/docs/_images/java/JVM/jvm-pc-counter.png and /dev/null differ

diff --git a/docs/_images/java/JVM/jvm-stack-frame.png b/docs/_images/java/JVM/jvm-stack-frame.png

deleted file mode 100644

index 53b6fd1e63..0000000000

Binary files a/docs/_images/java/JVM/jvm-stack-frame.png and /dev/null differ

diff --git a/docs/_images/java/JVM/minorgc_0.png b/docs/_images/java/JVM/minorgc_0.png

deleted file mode 100644

index e7bc84da07..0000000000

Binary files a/docs/_images/java/JVM/minorgc_0.png and /dev/null differ

diff --git a/docs/_images/java/JVM/minorgc_end.png b/docs/_images/java/JVM/minorgc_end.png

deleted file mode 100644

index 99a808d32e..0000000000

Binary files a/docs/_images/java/JVM/minorgc_end.png and /dev/null differ

diff --git a/docs/_images/java/JVM/oom-end.png b/docs/_images/java/JVM/oom-end.png

deleted file mode 100644

index d78256bbf4..0000000000

Binary files a/docs/_images/java/JVM/oom-end.png and /dev/null differ

diff --git a/docs/_images/java/JVM/oom.png b/docs/_images/java/JVM/oom.png

deleted file mode 100644

index f452f0f13d..0000000000

Binary files a/docs/_images/java/JVM/oom.png and /dev/null differ

diff --git a/docs/_images/java/JVM/swapspace.png b/docs/_images/java/JVM/swapspace.png

deleted file mode 100644

index 6472c67ce5..0000000000

Binary files a/docs/_images/java/JVM/swapspace.png and /dev/null differ

diff --git a/docs/_images/java/JVM/toomanythread.png b/docs/_images/java/JVM/toomanythread.png

deleted file mode 100644

index 5657984e64..0000000000

Binary files a/docs/_images/java/JVM/toomanythread.png and /dev/null differ

diff --git "a/docs/_images/java/JVM/\345\240\206\345\206\205\345\255\230\347\251\272\351\227\264.png" "b/docs/_images/java/JVM/\345\240\206\345\206\205\345\255\230\347\251\272\351\227\264.png"

deleted file mode 100644

index 0ac7cd1298..0000000000

Binary files "a/docs/_images/java/JVM/\345\240\206\345\206\205\345\255\230\347\251\272\351\227\264.png" and /dev/null differ

diff --git "a/docs/_images/java/JVM/\345\244\215\345\210\266\347\256\227\346\263\225.png" "b/docs/_images/java/JVM/\345\244\215\345\210\266\347\256\227\346\263\225.png"

deleted file mode 100644

index 85d6e5cffd..0000000000

Binary files "a/docs/_images/java/JVM/\345\244\215\345\210\266\347\256\227\346\263\225.png" and /dev/null differ

diff --git a/docs/_images/mysql/.DS_Store b/docs/_images/mysql/.DS_Store

index 1b4d8ddc7e..0e7bf57afa 100644

Binary files a/docs/_images/mysql/.DS_Store and b/docs/_images/mysql/.DS_Store differ

diff --git a/docs/_images/mysql/ACID.jpg b/docs/_images/mysql/ACID.jpg

deleted file mode 100644

index b4d61b7839..0000000000

Binary files a/docs/_images/mysql/ACID.jpg and /dev/null differ

diff --git a/docs/_images/mysql/BTree-vs-B+Tree.png b/docs/_images/mysql/BTree-vs-B+Tree.png

deleted file mode 100644

index 5aaa92502d..0000000000

Binary files a/docs/_images/mysql/BTree-vs-B+Tree.png and /dev/null differ

diff --git a/docs/_images/mysql/COMPACT-And-REDUNDANT-Row-Format.jpg b/docs/_images/mysql/COMPACT-And-REDUNDANT-Row-Format.jpg

deleted file mode 100644

index ac01b41a4c..0000000000

Binary files a/docs/_images/mysql/COMPACT-And-REDUNDANT-Row-Format.jpg and /dev/null differ

diff --git a/docs/_images/mysql/Infimum-Rows-Supremum.jpg b/docs/_images/mysql/Infimum-Rows-Supremum.jpg

deleted file mode 100644

index 2894d4b105..0000000000

Binary files a/docs/_images/mysql/Infimum-Rows-Supremum.jpg and /dev/null differ

diff --git a/docs/_images/mysql/InnoDB-B-Tree-Node.jpg b/docs/_images/mysql/InnoDB-B-Tree-Node.jpg

deleted file mode 100644

index 22409dfe63..0000000000

Binary files a/docs/_images/mysql/InnoDB-B-Tree-Node.jpg and /dev/null differ

diff --git a/docs/_images/mysql/MySQL-architecture.png b/docs/_images/mysql/MySQL-architecture.png

deleted file mode 100644

index f1bb2fbf21..0000000000

Binary files a/docs/_images/mysql/MySQL-architecture.png and /dev/null differ

diff --git a/docs/_images/mysql/bTree.png b/docs/_images/mysql/bTree.png

deleted file mode 100644

index c25ab404d3..0000000000

Binary files a/docs/_images/mysql/bTree.png and /dev/null differ

diff --git a/docs/_images/mysql/composite-index.png b/docs/_images/mysql/composite-index.png

deleted file mode 100644

index 6e274d0701..0000000000

Binary files a/docs/_images/mysql/composite-index.png and /dev/null differ

diff --git a/docs/_images/mysql/disk-io.png b/docs/_images/mysql/disk-io.png

deleted file mode 100644

index 09659f5f8c..0000000000

Binary files a/docs/_images/mysql/disk-io.png and /dev/null differ

diff --git a/docs/_images/mysql/expalin.jpg b/docs/_images/mysql/expalin.jpg

deleted file mode 100644

index da052f7fe6..0000000000

Binary files a/docs/_images/mysql/expalin.jpg and /dev/null differ

diff --git a/docs/_images/mysql/explain-key.png b/docs/_images/mysql/explain-key.png

deleted file mode 100644

index 5d4f617e2f..0000000000

Binary files a/docs/_images/mysql/explain-key.png and /dev/null differ

diff --git a/docs/_images/mysql/index-background.jpeg b/docs/_images/mysql/index-background.jpeg

deleted file mode 100644

index 63d2ca1bd9..0000000000

Binary files a/docs/_images/mysql/index-background.jpeg and /dev/null differ

diff --git a/docs/_images/mysql/optimization-orderby.png b/docs/_images/mysql/optimization-orderby.png

deleted file mode 100644

index d13f3656b6..0000000000

Binary files a/docs/_images/mysql/optimization-orderby.png and /dev/null differ

diff --git a/docs/_images/mysql/tablespace-segment-extent-page-row.jpg b/docs/_images/mysql/tablespace-segment-extent-page-row.jpg

deleted file mode 100644

index 66db246165..0000000000

Binary files a/docs/_images/mysql/tablespace-segment-extent-page-row.jpg and /dev/null differ

diff --git a/docs/_images/redis/.DS_Store b/docs/_images/redis/.DS_Store

deleted file mode 100644

index bf1618e94f..0000000000

Binary files a/docs/_images/redis/.DS_Store and /dev/null differ

diff --git a/docs/_images/redis/CLIENT_DIRTY_CAS.png b/docs/_images/redis/CLIENT_DIRTY_CAS.png

deleted file mode 100644

index a6c6cbc1ea..0000000000

Binary files a/docs/_images/redis/CLIENT_DIRTY_CAS.png and /dev/null differ

diff --git a/docs/_images/redis/RLock-UML.png b/docs/_images/redis/RLock-UML.png

deleted file mode 100644

index b8c878acf7..0000000000

Binary files a/docs/_images/redis/RLock-UML.png and /dev/null differ

diff --git a/docs/_images/redis/RLock.png b/docs/_images/redis/RLock.png

deleted file mode 100644

index 95e0e9a3ba..0000000000

Binary files a/docs/_images/redis/RLock.png and /dev/null differ

diff --git a/docs/_images/redis/bgrewriteaof.png b/docs/_images/redis/bgrewriteaof.png

deleted file mode 100644

index c180db8a1c..0000000000

Binary files a/docs/_images/redis/bgrewriteaof.png and /dev/null differ

diff --git a/docs/_images/redis/bitmap1.gif b/docs/_images/redis/bitmap1.gif

deleted file mode 100644

index f1e5916fa6..0000000000

Binary files a/docs/_images/redis/bitmap1.gif and /dev/null differ

diff --git a/docs/_images/redis/bitmap2.gif b/docs/_images/redis/bitmap2.gif

deleted file mode 100644

index 7ee3a1509b..0000000000

Binary files a/docs/_images/redis/bitmap2.gif and /dev/null differ

diff --git a/docs/_images/redis/c-string.jpg b/docs/_images/redis/c-string.jpg

deleted file mode 100644

index f53ed206f9..0000000000

Binary files a/docs/_images/redis/c-string.jpg and /dev/null differ

diff --git a/docs/_images/redis/cluster-info.png b/docs/_images/redis/cluster-info.png

deleted file mode 100644

index 1c270fed92..0000000000

Binary files a/docs/_images/redis/cluster-info.png and /dev/null differ

diff --git a/docs/_images/redis/data-type-structure.jpg b/docs/_images/redis/data-type-structure.jpg

deleted file mode 100644

index 0d9540e811..0000000000

Binary files a/docs/_images/redis/data-type-structure.jpg and /dev/null differ

diff --git a/docs/_images/redis/mq.jpg b/docs/_images/redis/mq.jpg

deleted file mode 100644

index 092a50c599..0000000000

Binary files a/docs/_images/redis/mq.jpg and /dev/null differ

diff --git a/docs/_images/redis/nosql-index.jpg b/docs/_images/redis/nosql-index.jpg

deleted file mode 100644

index 9eb9900db9..0000000000

Binary files a/docs/_images/redis/nosql-index.jpg and /dev/null differ

diff --git a/docs/_images/redis/nosqlwhy.png b/docs/_images/redis/nosqlwhy.png

deleted file mode 100644

index 0b299c4c19..0000000000

Binary files a/docs/_images/redis/nosqlwhy.png and /dev/null differ

diff --git a/docs/_images/redis/redis-aof-conf.jpg b/docs/_images/redis/redis-aof-conf.jpg

deleted file mode 100644

index a12c68cdaa..0000000000

Binary files a/docs/_images/redis/redis-aof-conf.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-aof-conf.png b/docs/_images/redis/redis-aof-conf.png

deleted file mode 100644

index 55d2f09535..0000000000

Binary files a/docs/_images/redis/redis-aof-conf.png and /dev/null differ

diff --git a/docs/_images/redis/redis-aof-file.png b/docs/_images/redis/redis-aof-file.png

deleted file mode 100644

index 6f6c2eed04..0000000000

Binary files a/docs/_images/redis/redis-aof-file.png and /dev/null differ

diff --git a/docs/_images/redis/redis-aof-rewrite-work.png b/docs/_images/redis/redis-aof-rewrite-work.png

deleted file mode 100644

index 10f919c7b1..0000000000

Binary files a/docs/_images/redis/redis-aof-rewrite-work.png and /dev/null differ

diff --git a/docs/_images/redis/redis-aof-summary.png b/docs/_images/redis/redis-aof-summary.png

deleted file mode 100644

index 80d9d01f38..0000000000

Binary files a/docs/_images/redis/redis-aof-summary.png and /dev/null differ

diff --git a/docs/_images/redis/redis-aof-write-log.png b/docs/_images/redis/redis-aof-write-log.png

deleted file mode 100644

index c10f2933b9..0000000000

Binary files a/docs/_images/redis/redis-aof-write-log.png and /dev/null differ

diff --git a/docs/_images/redis/redis-backlog_buffer.jpg b/docs/_images/redis/redis-backlog_buffer.jpg

deleted file mode 100644

index 27552e4945..0000000000

Binary files a/docs/_images/redis/redis-backlog_buffer.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-backlog_buffer.png b/docs/_images/redis/redis-backlog_buffer.png

deleted file mode 100644

index 3770fefc90..0000000000

Binary files a/docs/_images/redis/redis-backlog_buffer.png and /dev/null differ

diff --git a/docs/_images/redis/redis-bgsave.jpg b/docs/_images/redis/redis-bgsave.jpg

deleted file mode 100644

index e74b3ab9e2..0000000000

Binary files a/docs/_images/redis/redis-bgsave.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-bgsave.png b/docs/_images/redis/redis-bgsave.png

deleted file mode 100644

index 85fed50b84..0000000000

Binary files a/docs/_images/redis/redis-bgsave.png and /dev/null differ

diff --git a/docs/_images/redis/redis-cap.png b/docs/_images/redis/redis-cap.png

deleted file mode 100644

index 9a16045c7f..0000000000

Binary files a/docs/_images/redis/redis-cap.png and /dev/null differ

diff --git a/docs/_images/redis/redis-cg-commands.png b/docs/_images/redis/redis-cg-commands.png

deleted file mode 100644

index 45919a7063..0000000000

Binary files a/docs/_images/redis/redis-cg-commands.png and /dev/null differ

diff --git a/docs/_images/redis/redis-cluster-framework.png b/docs/_images/redis/redis-cluster-framework.png

deleted file mode 100644

index 6802ac9e60..0000000000

Binary files a/docs/_images/redis/redis-cluster-framework.png and /dev/null differ

diff --git a/docs/_images/redis/redis-cluster-new.jpg b/docs/_images/redis/redis-cluster-new.jpg

deleted file mode 100644

index fb9032fcfe..0000000000

Binary files a/docs/_images/redis/redis-cluster-new.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-cluster-ping.png b/docs/_images/redis/redis-cluster-ping.png

deleted file mode 100644

index 9e85719ac8..0000000000

Binary files a/docs/_images/redis/redis-cluster-ping.png and /dev/null differ

diff --git a/docs/_images/redis/redis-cluster-slot.png b/docs/_images/redis/redis-cluster-slot.png

deleted file mode 100644

index 230d2ccac0..0000000000

Binary files a/docs/_images/redis/redis-cluster-slot.png and /dev/null differ

diff --git a/docs/_images/redis/redis-cluster-vote.png b/docs/_images/redis/redis-cluster-vote.png

deleted file mode 100644

index e9a2f97c6e..0000000000

Binary files a/docs/_images/redis/redis-cluster-vote.png and /dev/null differ

diff --git a/docs/_images/redis/redis-consistency.png b/docs/_images/redis/redis-consistency.png

deleted file mode 100644

index c840f20b96..0000000000

Binary files a/docs/_images/redis/redis-consistency.png and /dev/null differ

diff --git a/docs/_images/redis/redis-gossip.png b/docs/_images/redis/redis-gossip.png

deleted file mode 100644

index d3e44367ec..0000000000

Binary files a/docs/_images/redis/redis-gossip.png and /dev/null differ

diff --git a/docs/_images/redis/redis-group-strucure.png b/docs/_images/redis/redis-group-strucure.png

deleted file mode 100644

index 1f94555cb2..0000000000

Binary files a/docs/_images/redis/redis-group-strucure.png and /dev/null differ

diff --git a/docs/_images/redis/redis-hash.jpg b/docs/_images/redis/redis-hash.jpg

deleted file mode 100644

index 2f95be5e61..0000000000

Binary files a/docs/_images/redis/redis-hash.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-increment-copy.png b/docs/_images/redis/redis-increment-copy.png

deleted file mode 100644

index d0c39734a3..0000000000

Binary files a/docs/_images/redis/redis-increment-copy.png and /dev/null differ

diff --git a/docs/_images/redis/redis-kv-conflict.jpg b/docs/_images/redis/redis-kv-conflict.jpg

deleted file mode 100644

index 32025db80d..0000000000

Binary files a/docs/_images/redis/redis-kv-conflict.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-kv.jpg b/docs/_images/redis/redis-kv.jpg

deleted file mode 100644

index 1f032fa1de..0000000000

Binary files a/docs/_images/redis/redis-kv.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-lock-banner.jpg b/docs/_images/redis/redis-lock-banner.jpg

deleted file mode 100644

index ee596157cb..0000000000

Binary files a/docs/_images/redis/redis-lock-banner.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-master-slave-index.png b/docs/_images/redis/redis-master-slave-index.png

deleted file mode 100644

index d9d7a42c92..0000000000

Binary files a/docs/_images/redis/redis-master-slave-index.png and /dev/null differ

diff --git a/docs/_images/redis/redis-master-slave-mode.png b/docs/_images/redis/redis-master-slave-mode.png

deleted file mode 100644

index d9d7a42c92..0000000000

Binary files a/docs/_images/redis/redis-master-slave-mode.png and /dev/null differ

diff --git a/docs/_images/redis/redis-message-type.png b/docs/_images/redis/redis-message-type.png

deleted file mode 100644

index 0304c198f4..0000000000

Binary files a/docs/_images/redis/redis-message-type.png and /dev/null differ

diff --git a/docs/_images/redis/redis-mix-persistence-file.png b/docs/_images/redis/redis-mix-persistence-file.png

deleted file mode 100644

index db19558671..0000000000

Binary files a/docs/_images/redis/redis-mix-persistence-file.png and /dev/null differ

diff --git a/docs/_images/redis/redis-mix-persistence.png b/docs/_images/redis/redis-mix-persistence.png

deleted file mode 100644

index b15d20828a..0000000000

Binary files a/docs/_images/redis/redis-mix-persistence.png and /dev/null differ

diff --git a/docs/_images/redis/redis-mq-banner.jpg b/docs/_images/redis/redis-mq-banner.jpg

deleted file mode 100644

index fc3e6dea37..0000000000

Binary files a/docs/_images/redis/redis-mq-banner.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-psubscribe-demo.jpg b/docs/_images/redis/redis-psubscribe-demo.jpg

deleted file mode 100644

index 1151a2c0a0..0000000000

Binary files a/docs/_images/redis/redis-psubscribe-demo.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-psubscribe.jpg b/docs/_images/redis/redis-psubscribe.jpg

deleted file mode 100644

index 7db65740f6..0000000000

Binary files a/docs/_images/redis/redis-psubscribe.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-psubscribe.png b/docs/_images/redis/redis-psubscribe.png

deleted file mode 100644

index 58ab1599de..0000000000

Binary files a/docs/_images/redis/redis-psubscribe.png and /dev/null differ

diff --git a/docs/_images/redis/redis-psubscribe1.png b/docs/_images/redis/redis-psubscribe1.png

deleted file mode 100644

index d3979a6d67..0000000000

Binary files a/docs/_images/redis/redis-psubscribe1.png and /dev/null differ

diff --git a/docs/_images/redis/redis-pub-sub.png b/docs/_images/redis/redis-pub-sub.png

deleted file mode 100644

index b2ae50d962..0000000000

Binary files a/docs/_images/redis/redis-pub-sub.png and /dev/null differ

diff --git a/docs/_images/redis/redis-pub_sub.jpg b/docs/_images/redis/redis-pub_sub.jpg

deleted file mode 100644

index 55d307ab0b..0000000000

Binary files a/docs/_images/redis/redis-pub_sub.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-publish.jpg b/docs/_images/redis/redis-publish.jpg

deleted file mode 100644

index 74554c3ca5..0000000000

Binary files a/docs/_images/redis/redis-publish.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-publish.png b/docs/_images/redis/redis-publish.png

deleted file mode 100644

index fe9d88da26..0000000000

Binary files a/docs/_images/redis/redis-publish.png and /dev/null differ

diff --git a/docs/_images/redis/redis-rdb-bak.jpg b/docs/_images/redis/redis-rdb-bak.jpg

deleted file mode 100644

index c372b38599..0000000000

Binary files a/docs/_images/redis/redis-rdb-bak.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-rdb-bak.png b/docs/_images/redis/redis-rdb-bak.png

deleted file mode 100644

index 31c538690f..0000000000

Binary files a/docs/_images/redis/redis-rdb-bak.png and /dev/null differ

diff --git a/docs/_images/redis/redis-rdb-file.jpg b/docs/_images/redis/redis-rdb-file.jpg

deleted file mode 100644

index 8aaaed90a3..0000000000

Binary files a/docs/_images/redis/redis-rdb-file.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-rdb-file.png b/docs/_images/redis/redis-rdb-file.png

deleted file mode 100644

index 81e2e0ed6a..0000000000

Binary files a/docs/_images/redis/redis-rdb-file.png and /dev/null differ

diff --git a/docs/_images/redis/redis-rdb-summary.jpg b/docs/_images/redis/redis-rdb-summary.jpg

deleted file mode 100644

index 5d427afaef..0000000000

Binary files a/docs/_images/redis/redis-rdb-summary.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-rdb-summary.png b/docs/_images/redis/redis-rdb-summary.png

deleted file mode 100644

index c65b393bd3..0000000000

Binary files a/docs/_images/redis/redis-rdb-summary.png and /dev/null differ

diff --git a/docs/_images/redis/redis-rdb.png b/docs/_images/redis/redis-rdb.png

deleted file mode 100644

index 0279a22be3..0000000000

Binary files a/docs/_images/redis/redis-rdb.png and /dev/null differ

diff --git a/docs/_images/redis/redis-readme-banner.jpg b/docs/_images/redis/redis-readme-banner.jpg

deleted file mode 100644

index ae239878bb..0000000000

Binary files a/docs/_images/redis/redis-readme-banner.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-reansaction-banner.jpg b/docs/_images/redis/redis-reansaction-banner.jpg

deleted file mode 100644

index 71c85ba90c..0000000000

Binary files a/docs/_images/redis/redis-reansaction-banner.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-rehash.jpg b/docs/_images/redis/redis-rehash.jpg

deleted file mode 100644

index 1cbe4c1ca6..0000000000

Binary files a/docs/_images/redis/redis-rehash.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-rehash.png b/docs/_images/redis/redis-rehash.png

deleted file mode 100644

index 374ef066e2..0000000000

Binary files a/docs/_images/redis/redis-rehash.png and /dev/null differ

diff --git a/docs/_images/redis/redis-replicaof.png b/docs/_images/redis/redis-replicaof.png

deleted file mode 100644

index 920ed8ca86..0000000000

Binary files a/docs/_images/redis/redis-replicaof.png and /dev/null differ

diff --git a/docs/_images/redis/redis-rpop.jpg b/docs/_images/redis/redis-rpop.jpg

deleted file mode 100644

index 44e235185d..0000000000

Binary files a/docs/_images/redis/redis-rpop.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-rpop.png b/docs/_images/redis/redis-rpop.png

deleted file mode 100644

index 0e15bfb30b..0000000000

Binary files a/docs/_images/redis/redis-rpop.png and /dev/null differ

diff --git a/docs/_images/redis/redis-rpoplpush.jpg b/docs/_images/redis/redis-rpoplpush.jpg

deleted file mode 100644

index 5628234856..0000000000

Binary files a/docs/_images/redis/redis-rpoplpush.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-rpoplpush.png b/docs/_images/redis/redis-rpoplpush.png

deleted file mode 100644

index f91da98939..0000000000

Binary files a/docs/_images/redis/redis-rpoplpush.png and /dev/null differ

diff --git a/docs/_images/redis/redis-sds.jpg b/docs/_images/redis/redis-sds.jpg

deleted file mode 100644

index 4d74127985..0000000000

Binary files a/docs/_images/redis/redis-sds.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-select-master.png b/docs/_images/redis/redis-select-master.png

deleted file mode 100644

index e5f4d2bbdd..0000000000

Binary files a/docs/_images/redis/redis-select-master.png and /dev/null differ

diff --git a/docs/_images/redis/redis-sentinel-cluster.png b/docs/_images/redis/redis-sentinel-cluster.png

deleted file mode 100644

index 6029c71e13..0000000000

Binary files a/docs/_images/redis/redis-sentinel-cluster.png and /dev/null differ

diff --git a/docs/_images/redis/redis-sentinel-ps.png b/docs/_images/redis/redis-sentinel-ps.png

deleted file mode 100644

index 7bf9f6471a..0000000000

Binary files a/docs/_images/redis/redis-sentinel-ps.png and /dev/null differ

diff --git a/docs/_images/redis/redis-sentinel-select-master.jpg b/docs/_images/redis/redis-sentinel-select-master.jpg

deleted file mode 100644

index 090b4297c9..0000000000

Binary files a/docs/_images/redis/redis-sentinel-select-master.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-sentinel-slave.png b/docs/_images/redis/redis-sentinel-slave.png

deleted file mode 100644

index 1ef37adbf4..0000000000

Binary files a/docs/_images/redis/redis-sentinel-slave.png and /dev/null differ

diff --git a/docs/_images/redis/redis-sentinel.png b/docs/_images/redis/redis-sentinel.png

deleted file mode 100644

index d256f130dd..0000000000

Binary files a/docs/_images/redis/redis-sentinel.png and /dev/null differ

diff --git a/docs/_images/redis/redis-set.gif b/docs/_images/redis/redis-set.gif

deleted file mode 100644

index 3e511647fe..0000000000

Binary files a/docs/_images/redis/redis-set.gif and /dev/null differ

diff --git a/docs/_images/redis/redis-setkv-aof.png b/docs/_images/redis/redis-setkv-aof.png

deleted file mode 100644

index 4d31075e18..0000000000

Binary files a/docs/_images/redis/redis-setkv-aof.png and /dev/null differ

diff --git a/docs/_images/redis/redis-snapshotting.jpg b/docs/_images/redis/redis-snapshotting.jpg

deleted file mode 100644

index 58e787fb1b..0000000000

Binary files a/docs/_images/redis/redis-snapshotting.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-snapshotting.png b/docs/_images/redis/redis-snapshotting.png

deleted file mode 100644

index 4a39a8868f..0000000000

Binary files a/docs/_images/redis/redis-snapshotting.png and /dev/null differ

diff --git a/docs/_images/redis/redis-stream-cg.jpg b/docs/_images/redis/redis-stream-cg.jpg

deleted file mode 100644

index 7d78098f05..0000000000

Binary files a/docs/_images/redis/redis-stream-cg.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-stream-cg.png b/docs/_images/redis/redis-stream-cg.png

deleted file mode 100644

index 4dba663ec1..0000000000

Binary files a/docs/_images/redis/redis-stream-cg.png and /dev/null differ

diff --git a/docs/_images/redis/redis-stream.png b/docs/_images/redis/redis-stream.png

deleted file mode 100644

index a46e76e04f..0000000000

Binary files a/docs/_images/redis/redis-stream.png and /dev/null differ

diff --git a/docs/_images/redis/redis-string-length.jpg b/docs/_images/redis/redis-string-length.jpg

deleted file mode 100644

index 5f907a1214..0000000000

Binary files a/docs/_images/redis/redis-string-length.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-string.jpg b/docs/_images/redis/redis-string.jpg

deleted file mode 100644

index 3c4625ae76..0000000000

Binary files a/docs/_images/redis/redis-string.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-subscribe.jpg b/docs/_images/redis/redis-subscribe.jpg

deleted file mode 100644

index d8c5c8e3bd..0000000000

Binary files a/docs/_images/redis/redis-subscribe.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-subscribe.png b/docs/_images/redis/redis-subscribe.png

deleted file mode 100644

index 510f5146e8..0000000000

Binary files a/docs/_images/redis/redis-subscribe.png and /dev/null differ

diff --git a/docs/_images/redis/redis-transaction-case1.png b/docs/_images/redis/redis-transaction-case1.png

deleted file mode 100644

index 33c0c28b86..0000000000

Binary files a/docs/_images/redis/redis-transaction-case1.png and /dev/null differ

diff --git a/docs/_images/redis/redis-transaction-case2.png b/docs/_images/redis/redis-transaction-case2.png

deleted file mode 100644

index bb6478bf6b..0000000000

Binary files a/docs/_images/redis/redis-transaction-case2.png and /dev/null differ

diff --git a/docs/_images/redis/redis-transaction-case3.png b/docs/_images/redis/redis-transaction-case3.png

deleted file mode 100644

index dc8a3d47f1..0000000000

Binary files a/docs/_images/redis/redis-transaction-case3.png and /dev/null differ

diff --git a/docs/_images/redis/redis-transaction-case4.png b/docs/_images/redis/redis-transaction-case4.png

deleted file mode 100644

index 75e37e2cdc..0000000000

Binary files a/docs/_images/redis/redis-transaction-case4.png and /dev/null differ

diff --git a/docs/_images/redis/redis-transaction-client-cut.png b/docs/_images/redis/redis-transaction-client-cut.png

deleted file mode 100644

index a6c6cbc1ea..0000000000

Binary files a/docs/_images/redis/redis-transaction-client-cut.png and /dev/null differ

diff --git a/docs/_images/redis/redis-transaction-watch1.png b/docs/_images/redis/redis-transaction-watch1.png

deleted file mode 100644

index 168d241076..0000000000

Binary files a/docs/_images/redis/redis-transaction-watch1.png and /dev/null differ

diff --git a/docs/_images/redis/redis-transaction-watch2.png b/docs/_images/redis/redis-transaction-watch2.png

deleted file mode 100644

index 8a0e0fd888..0000000000

Binary files a/docs/_images/redis/redis-transaction-watch2.png and /dev/null differ

diff --git a/docs/_images/redis/redis-transaction-watch3.png b/docs/_images/redis/redis-transaction-watch3.png

deleted file mode 100644

index 9470a87ac0..0000000000

Binary files a/docs/_images/redis/redis-transaction-watch3.png and /dev/null differ

diff --git a/docs/_images/redis/redis-transaction-watch4.png b/docs/_images/redis/redis-transaction-watch4.png

deleted file mode 100644

index b903cb109b..0000000000

Binary files a/docs/_images/redis/redis-transaction-watch4.png and /dev/null differ

diff --git a/docs/_images/redis/redis-watch-client99.png b/docs/_images/redis/redis-watch-client99.png

deleted file mode 100644

index f27d10c410..0000000000

Binary files a/docs/_images/redis/redis-watch-client99.png and /dev/null differ

diff --git a/docs/_images/redis/redis-watch-key.png b/docs/_images/redis/redis-watch-key.png

deleted file mode 100644

index 0c4822bd24..0000000000

Binary files a/docs/_images/redis/redis-watch-key.png and /dev/null differ

diff --git a/docs/_images/redis/redis-watch.png b/docs/_images/redis/redis-watch.png

deleted file mode 100644

index f27d10c410..0000000000

Binary files a/docs/_images/redis/redis-watch.png and /dev/null differ

diff --git a/docs/_images/redis/redis-xgroup.jpg b/docs/_images/redis/redis-xgroup.jpg

deleted file mode 100644

index b1656875b2..0000000000

Binary files a/docs/_images/redis/redis-xgroup.jpg and /dev/null differ

diff --git a/docs/_images/redis/redis-zset-code.svg b/docs/_images/redis/redis-zset-code.svg

deleted file mode 100644

index 67bde867f4..0000000000

--- a/docs/_images/redis/redis-zset-code.svg

+++ /dev/null

@@ -1 +0,0 @@

-

\ No newline at end of file

diff --git a/docs/_images/redis/redis-zset.gif b/docs/_images/redis/redis-zset.gif

deleted file mode 100644

index 826a5ceef4..0000000000

Binary files a/docs/_images/redis/redis-zset.gif and /dev/null differ

diff --git a/docs/_images/redis/rehash.gif b/docs/_images/redis/rehash.gif

deleted file mode 100644

index cc9edcc425..0000000000

Binary files a/docs/_images/redis/rehash.gif and /dev/null differ

diff --git a/docs/_images/redis/watched_keys.png b/docs/_images/redis/watched_keys.png

deleted file mode 100644

index 0c4822bd24..0000000000

Binary files a/docs/_images/redis/watched_keys.png and /dev/null differ

diff --git a/docs/_images/redis/zset.svg b/docs/_images/redis/zset.svg

deleted file mode 100644

index 67bde867f4..0000000000

--- a/docs/_images/redis/zset.svg

+++ /dev/null

@@ -1 +0,0 @@

-

\ No newline at end of file

diff --git "a/docs/architecture/\347\247\222\346\235\200\347\263\273\347\273\237\350\256\276\350\256\241.md" "b/docs/architecture/\347\247\222\346\235\200\347\263\273\347\273\237\350\256\276\350\256\241.md"

new file mode 100755

index 0000000000..bd47b14253

--- /dev/null

+++ "b/docs/architecture/\347\247\222\346\235\200\347\263\273\347\273\237\350\256\276\350\256\241.md"

@@ -0,0 +1,26 @@

+**秒杀系统本质上就是一个满足大并发、高性能和高可用的分布式系统**。

+

+## 架构原则:“4 要 1 不要”

+

+1. 数据要尽量少

+

+ 所谓“数据要尽量少”,首先是指用户请求的数据能少就少。请求的数据包括上传给系统的数据和系统返回给用户 的数据(通常就是网页)。

+

+2. 请求数要尽量少

+3. 路径要尽量短

+4. 依赖要尽量少

+5. 不要有单点

+

+

+

+# 动静分离

+

+所谓“动静分离”,其实就是把用户请求的数据(如 HTML 页面)划分为“动态数据”和“静态数据”。

+

+**第一,你应该把静态数据缓存到离用户最近的地方**。静态数据就是那些相对不会变化的数据,因此我们可以把它们缓存起来。缓存到哪里呢?常见的就三种,用户浏览器里、CDN 上或者在服务端的 Cache 中。你应该根据情况,把它们尽量缓存到离用户最近的地方。

+

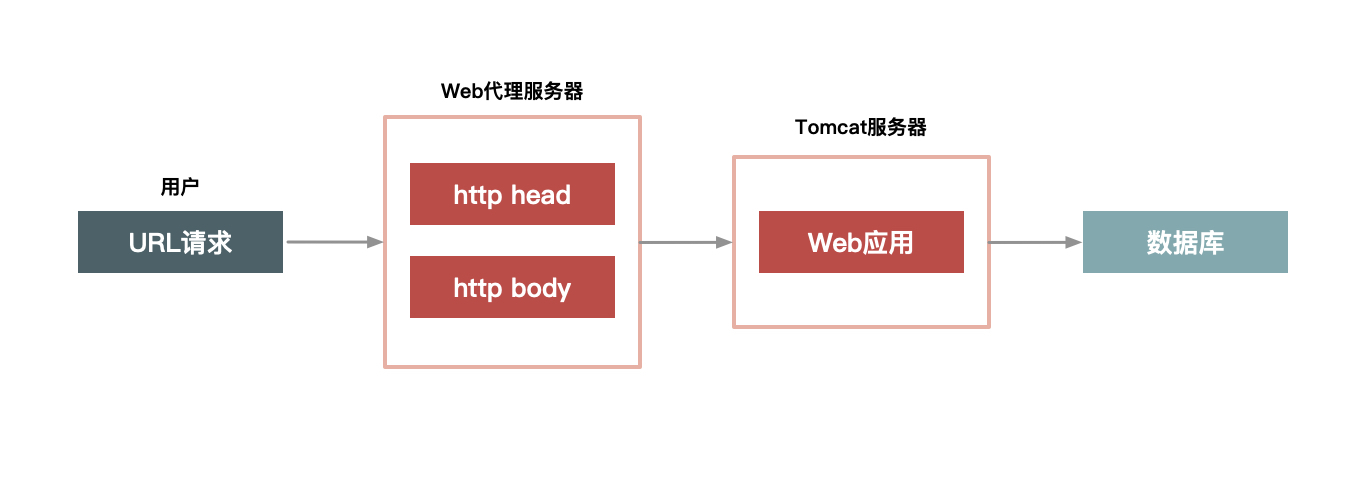

+**第二,静态化改造就是要直接缓存 HTTP 连接**。相较于普通的数据缓存而言,你肯定还听过系统的静态化改造。静态化改造是直接缓存 HTTP 连接而不是仅仅缓存数据,如下图所示,Web 代理服务器根据请求 URL,直接取出对应的 HTTP 响应头和响应体然后直接返回,这个响应过程简单得连 HTTP 协议都不用重新组装,甚至连 HTTP 请求头也不需要解析。

+

+

+

+第三,让谁来缓存静态数据也很重要。不同语言写的 Cache 软件处理缓存数据的效率也各不相同。以 Java 为例,因为 Java 系统本身也有其弱点(比如不擅长处理大量连接请求,每个连接消耗的内存较多,Servlet 容器解析 HTTP 协议较慢),所以你可以不在 Java 层做缓存,而是直接在 Web 服务器层上做,这样你就可以屏蔽 Java 语言层面的一些弱点;而相比起来,Web 服务器(如 Nginx、Apache、Varnish)也更擅长处理大并发的静态文件请求。

\ No newline at end of file

diff --git a/docs/data-management/.DS_Store b/docs/data-management/.DS_Store

index 669936cb49..c40a6e6781 100644

Binary files a/docs/data-management/.DS_Store and b/docs/data-management/.DS_Store differ

diff --git a/docs/data-management/Big-Data/.DS_Store b/docs/data-management/Big-Data/.DS_Store

index b0c3898aa2..b24b0adada 100644

Binary files a/docs/data-management/Big-Data/.DS_Store and b/docs/data-management/Big-Data/.DS_Store differ

diff --git a/docs/data-management/Big-Data/Bloom-Filter.md b/docs/data-management/Big-Data/Bloom-Filter.md

index a575e78e75..9bffa3d59d 100644

--- a/docs/data-management/Big-Data/Bloom-Filter.md

+++ b/docs/data-management/Big-Data/Bloom-Filter.md

@@ -387,11 +387,11 @@ public class RedissonBloomFilterDemo {

## 参考与感谢

-https://www.cs.cmu.edu/~dga/papers/cuckoo-conext2014.pdf

+- https://www.cs.cmu.edu/~dga/papers/cuckoo-conext2014.pdf

-http://www.justdojava.com/2019/10/22/bloomfilter/

+- http://www.justdojava.com/2019/10/22/bloomfilter/

-https://www.cnblogs.com/cpselvis/p/6265825.html

+- https://www.cnblogs.com/cpselvis/p/6265825.html

-https://juejin.im/post/5cc5aa7ce51d456e431adac5

+- https://juejin.im/post/5cc5aa7ce51d456e431adac5

diff --git a/docs/data-management/Big-Data/Doris.md b/docs/data-management/Big-Data/Doris.md

index c1a5e81b83..2a649d38a9 100644

--- a/docs/data-management/Big-Data/Doris.md

+++ b/docs/data-management/Big-Data/Doris.md

@@ -1,13 +1,14 @@

-当前大部分业务数据经过一定处理以后保存到 Hive (依托 HDFS 存储系统),使用 HiveSQL 进行离线数据分析,主要 MOLAP 引擎为 Kylin (MOLAP 是预计算生产,在增量业务,预设维度分析场景下表现良好),业务事务性分析使用 MySQL。有以下痛点:

+## 背景

-- 应用层模型复杂,根据业务需要以及Kylin生产需要,还要做较多模型预处理。这样在不同的业务场景中,模型的利用率也比较低。

-- Kylin配置过程繁琐,需要配置模型设计,并配合适当的“剪枝”策略,以实现计算成本与查询效率的平衡。

-- 由于MOLAP不支持明细数据的查询,在“汇总+明细”的应用场景中,明细数据需要同步到DBMS引擎来响应交互,增加了生产的运维成本。

-- 较多的预处理伴随着较高的生产成本。

+Doris 由百度大数据部研发 ( 之前叫百度 Palo,2018年贡献到 Apache 社区后,更名为 Apache Doris ), Doris 从最初的只为解决百度凤巢报表的专用系统,到现在在百度内部,已有有超过200个产品线在使用,部署机器超过1000台,单一业务最大可达到上百 TB。

+Apache Doris 作为一款开源的 MPP 分析型数据库产品,主要用于解决近实时的报表和多维分析。不仅能够在亚秒级响应时间即可获得查询结果,有效的支持实时数据分析。相较于其他业界比较火的 OLAP 数据库系统,Doris 的分布式架构非常简洁,支持弹性伸缩,易于运维,节省大量人力和时间成本。目前国内社区比较活跃,也有腾讯、京东、美团、小米等大厂在使用。

+## 功能特性

+

+

diff --git a/docs/data-management/Big-Data/HBase.md b/docs/data-management/Big-Data/HBase.md

index 8a6cd5db76..d34e43f028 100755

--- a/docs/data-management/Big-Data/HBase.md

+++ b/docs/data-management/Big-Data/HBase.md

@@ -1,11 +1,19 @@

+---

+title: HBase

+date: 2023-03-09

+tags:

+ - HBase

+categories: Big Data

+---

+

+

+

# 一、HBase 简介

### 1.1 HBase 定义

HBase 是一种分布式、可扩展、支持海量数据存储的 NoSQL 数据库。

-

-

### 1.2 HBase 的起源

HBase 是一个基于 HDFS 的分布式、面向列的开源数据库,是一个结构化数据的分布式存储系统,利用 HBase 技术可在廉价 PC Server上搭建起大规模结构化存储集群。